Il trigger e l'acquisizione dei dati

Scritto da Enrico Pasqualucci, aggiornato da Andrea Negri

Introduzione

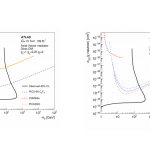

Il sistema di Trigger e Acquisizione Dati di ATLAS (TDAQ) opera in un ambiente sperimentale particolarmente difficile e nuovo quale quello di LHC, caratterizzato da 109 interazioni al secondo, un rivelatore complesso e di grandi dimensioni con circa 108 canali di lettura, una frequenza di collisione dei bunch di protoni di 40 MHz che richiede una decisione del trigger sulla bontà dell’evento ogni 25 ns e con una limitazione di scrittura dati su memoria di massa che nel run 2 sarà di circa 1 GB/s.

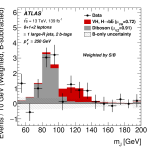

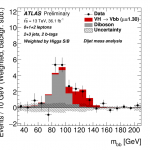

L’obbiettivo primario del TDAQ di ATLAS è quello di separare con elevata efficienza i processi di fisica rari dalla maggioranza degli eventi di fondo. Il sistema deve inoltre possedere grande flessibilità in modo da potersi adattare alle condizioni variabili di luminosità, fondo e misure di fisica. A tale scopo il TDAQ è realizzato su vari livelli di selezione che operano globalmente una riduzione della frequenza degli eventi di un fattore di circa 105, applicando in sequenza criteri di selezione di complessità crescente.

Architettura del sistema TDAQ

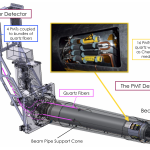

Una rappresentazione schematica dell’architettura TDAQ di ATLAS è riportata in Fig. 1.

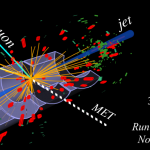

Il trigger di primo livello (L1) è realizzato con hardware dedicato e opera una selezione rapida e mirata degli eventi, analizzando i dati provenienti dai calorimetri e dalle camere di trigger dello spettrometro per muoni. Non è possibile, a causa della complessità delle informazioni da analizzare, utilizzare anche l’Inner Detector a questo stadio di selezione. Il tempo di latenza (ossia il tempo disponibile ad elaborare e distribuire la decisione del trigger) è fissato a 2.5 μs e la frequenza degli eventi accettati non deve superare 100 kHz. Durante l’elaborazione i dati vengono conservati in memorie cosiddette pipeline realizzate in circuiti appositamente sviluppati e altamente integrati (ASIC) e posizionati sui rivelatori (FE in figura), ossia vicinissimi a dove viene prodotto il segnale successivamente convertito in informazione digitale. I dati relativi agli eventi selezionati dal L1 vengono trasportati dai sistema di lettura (readout) nelle memorie tampone del sistema di acquisizione dati (ROB).

I trigger di alto livello (HLT) sono invece composti da farm di processori commerciali che accedono ai dati contenuti nei ROB. All’inizio del run 2, nella primavera del 2015, la farm sarà composta da circa 20000 processori (core) collegati da una rete a grande velocità basata su fibre ottiche a 10Gb/s. Gli HLT hanno il compito di ridurre il rate dai 100 kHz di uscita del L1 ad un valore ritenuto gestibile per la successiva fase di analisi dati: 500-1000 Hz, corrispondenti a ~ 1 GB/s. Gli HLT sono logicamente divisi in due livelli virtuali: il livello 2 (L2), che effettua una prima selezione accedendo esclusivamente ai dati corrispondenti alle regioni di interesse (RoI) indicate dall’L1, e l’event filter (EF), che invece opera su tutti i dati associati all’evento in questione. Siccome in ogni evento le RoI corrispondono a una piccola frazione percentuale dei dati (~5%), l’utilizzo del L2 permette una drastica riduzione della banda di acquisizione. Gli eventi accetati dal L1 sono distribuiti ai processori della farm: ognuno di essi esegue in successione gli algoritmi di selezione di L2 ed EF e, nel caso l’evento sia accetto, lo invia ai nodi di archiviazione (Data Logger). Questi ultimi salvano temporaneamente i dati su dischi locali e li inviano successivamente al sistema di storage del cern.

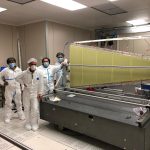

Nel corso del run 2, le potenzialità del sistema TDAQ saranno estese attraverso l’installazione del tracciatore hardware FastTracKer (FTK), un sistema massivamente parallelo basato su memorie associative. FTK sarà in grado di ricostruire in pochi microsecondi le traiettorie delle particelle nei rivelatori interni e renderele disponibili agli algoritmi di HLT.

Comments RSS Feed