Atlas, Atlas Rivelatore, Contributo Italiano, Fisica

Report da "XII workshop ATLAS Italia – Fisica e Upgrade"

La XII edizione del workshop sulla fisica e sull’upgrade di ATLAS, svoltasi a Napoli dal 23 al 25 novembre 2016, ha visto la partecipazione di più di 100 fisici provenienti da diversi istituti italiani. Sono stati presentati vari risultati sulle misure di fisica e ricerche di nuove particelle, nonché sulle prestazioni del rivelatore e sulle strategie di upgrade. A seguire, un breve estratto da ciascuna delle sessioni.

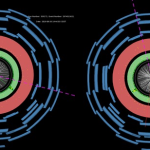

Le prestazioni dell’esperimento ATLAS nel 2016 (a cura di Andrea Ventura)

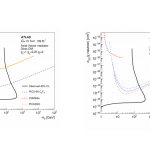

Il Large Hadron Collider durante il 2016 ha fatto registrare prestazioni superiori alle aspettative, sia in termini di luminosità istantanea (con un picco di 1.37·1034 cm-2s-1, ben al di sopra del valore di progetto e quasi tre volte più elevato rispetto al massimo registrato nel 2015) sia in termini di luminosità integrata (quasi 39 fb-1 forniti dall’acceleratore e 36 fb-1 registrati dall’esperimento ATLAS, come riportato in Fig. 1, corrispondenti a più di quanto raccolto in tutti gli anni precedenti messi assieme). Durante il 2016 tutti i sottosistemi di ATLAS, a partire dal trigger e dalle risorse di calcolo, hanno operato con elevate efficienze (superiore al 92% per quanto riguarda la presa dati) e bassissime incidenze di problemi relativi alle varie parti dell’apparato. Ulteriori miglioramenti si prospettano per il 2017.

Durante il 2016, i menu di trigger sono stati adattati in base alla crescente luminosità istantanea, tenendo conto delle priorità dettate dei programmi di fisica di ATLAS, come pure delle limitazioni imposte dai rate di eventi consentiti dal trigger e dall’acquisizione dati (~100 kHz al Livello 1 e fino a 1 kHz all’HLT, trigger di alto livello). Per il 2017 verranno discussi ed implementati nuovi menu di trigger per tenere conto dell’accresciuta luminosità e delle condizioni sempre più proibitive di pile-up che si raggiungeranno; verranno così definite soglie di momento trasverso (pT) via via più elevate e, specialmente nel caso dei leptoni, si applicheranno selezioni di qualità delle tracce e condizioni di isolamento sempre più stringenti. A titolo di esempio, si prevede che le soglie di pT all’HLT verranno impostate a 26 GeV/c per i muoni e a 28 GeV/c per gli elettroni, unitamente ad opportune richieste di isolamento, rendendo importanti trigger alternativi, come per esempio quelli basati su coppie di muoni (o di elettroni) per i quali le soglie potranno essere di 14 (o 17) GeV/c.

Un ruolo cruciale per le numerose analisi di fisica pubblicate da ATLAS è da attribuire al lavoro di servizio dei gruppi di Combined Performance, grazie ai quali è possibile affinare tutte le misure realizzate in termini di qualità e di precisione. Nel 2016, ad esempio, per quanto riguarda i muoni, la conoscenza delle efficienze è stata mappata in funzione delle coordinate spaziali (pseudorapidità η e angolo azimutale ϕ) e del pT con accuratezza mai raggiunta prima attraverso il metodo Tag&Probe, basato su decadimenti dimuonici dei bosoni Z e J/ψ, con un’estensione in pT che si spinge giù fino a soli 4 GeV/c. Come anche nel caso degli elettroni, sono stati forniti, al variare del periodo di presa dati, i fattori di scala utili a correggere le efficienze relative alle simulazioni Monte Carlo, al fine di riprodurre in modo ottimale le distribuzioni cinematiche osservate sui dati reali. Un interessante miglioramento nelle prestazioni degli algoritmi di ricostruzione riguarda il caso dei getti, in cui è allo studio un nuovo approccio, il Particle Flow, grazie al quale la risoluzione spaziale potrà migliorare notevolmente rispetto al passato, soprattutto a basso pT.

Le prestazioni del calcolo sono determinanti per il successo di ATLAS. Nel passaggio da una release di software a quella successiva, uno stesso campione di eventi simulati, impiegato come riferimento, viene ricostruito in tempi sempre più contenuti, con un miglioramento tra la release 17 e la 20 superiore a un fattore 3 in generale, e prossimo a 5 per la ricostruzione nel solo rivelatore interno, che è tra tutti quello più dispendioso in termini di risorse di calcolo richieste.

Risultati di fisica del Modello Standard – Ewk e Top (a cura di Sandra Leone)

Nella seconda sessione pomeridiana di mercoledì 23 novembre sono stati discussi i più recenti risultati di ATLAS riguardanti la fisica del Modello Standard (MS) delle particelle elementari. La comunità dei fisici italiani è coinvolta in tutti i gruppi di lavoro che si occupano di fisica del MS. Sono stati mostrati risultati riguardanti la fisica delle particelle contenenti quark b, con particolare attenzione ai mesoni B_s. Questi ultimi sono particolarmente interessanti per gli studi di violazione delle simmetrie CP: si tratta di un settore in cui piccole deviazioni da quanto previsto dal MS potrebbero indicare la presenza di “nuova fisica”. I risultati di ATLAS sono al momento consistenti con quanto osservato dagli altri esperimenti di LHC e con le previsioni del MS.

Anche la ricerca di decadimenti B0 -> μμ e B0s -> μμ, la cui sezione d’urto è calcolata teoricamente con grande precisione, e più in generale di decadimenti “rari” dei mesoni B, è molto rilevante perché può fornire indicazioni dell’esistenza di nuovi processi fisici. L’analisi dei dati raccolti a 13 TeV è ancora in corso e potrebbe riservare interessanti sorprese.

Per quanto riguarda la fisica dei bosoni intermedi W e Z, sono state misurate sezioni d’urto di produzione che spaziano, per i singoli processi, su 7 ordini di grandezza. Le misure delle proprietà dei bosoni W e Z sono fondamentali per la comprensione del funzionamento del rivelatore. Inoltre, questi processi costituiscono alcuni tra i fondi più importanti per la fisica del quark top e del bosone di Higgs e nella ricerca di eventi di “nuova fisica”. La misura della massa del bosone W è particolarmente importante poiché legata alle masse del quark top e del bosone di Higgs. Si tratta di una misura molto complessa, se si vuole raggiungere una precisione migliore di 15 MeV, che rappresenta la precisione sulla media delle misure della massa del W effettuate da precedenti esperimenti. La collaborazione ATLAS ha appena reso pubblica una misura sui dati a 7 TeV, che attesta la massa del W a 80370 ± 19 MeV (https://cds.cern.ch/record/2238954). La misura dei processi in cui sono prodotti simultaneamente due o più bosoni intermedi fornisce una finestra sull’esistenza di “nuova fisica”. Al momento tutte le misure fatte sono consistenti con le previsioni del MS.

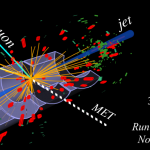

Misure di precisione sono state effettuate anche nell’ambito della fisica del quark top, la più pesante tra le particelle elementari, con una massa pari a quella di circa 180 protoni. Grazie a questa proprietà, il quark top decade prima di adronizzare (cioé prima di formare particelle composte da piùquarks) offrendoci quindi l’opportunità di studiare un quark “nudo”. Inoltre, il quark top gioca un ruolo importante in molti scenari di fisica non standard. Il quark top viene prodotto all’LHC sia singolarmente che in coppie top-antitop. Ogni quark top decade in un quark b e in un bosone W, che a sua volta decade in leptoni o quarks. Il programma di fisica del quark top ad ATLAS è molto ricco. Le proprietà dei processi di produzione del quark top sono state studiate in dettaglio in tutti i canali di decadimento previsti e sono risultate in accordo con le previsioni del MS (Fig. 2).

La sessione si è conclusa con una presentazione sulle prospettive di fisica oltre il Modello Standard, analizzando gli scenari che restano ancora aperti dopo i primi anni di funzionamento di LHC e l’osservazione del bosone di Higgs. Chi si aspettava che, all’accensione dell’LHC, una pletora di nuove particelle venisse osservata, è rimasto deluso. Eppure il Modello Standard, vista anche la relativamente piccola massa del bosone di Higgs, appare per molti aspetti “innaturale”: ci sono fondate ragioni per credere che si possa arrivare ad una comprensione più profonda della natura, al di là del quadro che il Modello Standard oggi ci offre. Una delle soluzioni più eleganti per il problema della naturalezza della massa del bosone di Higgs è la supersimmetria, una simmetria di un nuovo tipo che mette in relazione particelle con caratteristiche molto diverse, i bosoni e i fermioni. Tuttavia tale nuova simmetria non ha avuto al momento alcuna conferma sperimentale. Forse è giunto il momento che la fisica delle particelle torni ad essere una scienza “normale” cioè motivata dai risultati sperimentali: la ricerca sperimentale dunque, opportunamente diversificata, si deve riappropriare del suo ruolo pionieristico.

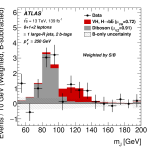

Aggiornamenti sul bosone di Higgs (a cura di Domizia Orestano)

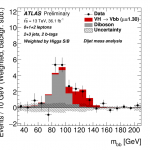

Nel workshop di ATLAS Italia sono stati discussi i risultati delle analisi finali sui dati del Run 1 a 7 e 8 TeV nel centro di massa e sul primo terzo dei dati acquisiti ad oggi nel Run 2, a 13 TeV. Sono state poi descritte le attività volte alla finalizzazione delle analisi sui restanti due terzi e le prospettive per il prossimo anno.

A oltre 4 anni dall’annuncio della sua scoperta il bosone di Higgs è ancora un particella elusiva e affascinante. Grazie alla dipendenza degli accoppiamenti con altre particelle dalla massa delle stesse, la fenomenologia dei processi che coinvolgono il bosone di Higgs è ampia e variegata. Solo dopo avere osservato e misurato con precisione la sua produzione attraverso diversi processi, tramite fusione gluone-gluone, fusione di bosoni vettoriali, irraggiamento da bosoni vettoriali o produzione associata con un coppia di quark top, ed i suoi decadimento sia in coppie di bosoni che di fermioni, sarà possibile caratterizzarlo completamente.

Sebbene per ridurre il fondo a volte si richieda qualche caratteristica legata al canale di produzione anche al resto dell’evento, l’identificazione degli eventi con la presenza del bosone di Higgs procede normalmente tramite l’identificazione delle particelle presenti nello stato finale e prodotte dal decadimento del bosone di Higgs stesso. Per questo motivo le diverse analisi che studiano questa particella sono generalmente strutturate in base al canale di decadimento.

Nel workshop sono stati presentati gli studi legati ai decadimenti in bosoni e quelli legati ai decadimenti in fermioni. Uno spazio a parte è stato dedicato agli studi sul canale di produzione associata con un coppia di quark top. Questo meccanismo infatti è quello più raro e ancora non osservato direttamente e dà luogo a stati finali estremamente complessi, nei quali oltre ai prodotti di decadimento del bosone di Higgs si affollano quelli del decadimento dei due quark top. Essendo il quark top la particella più pesante decade in stati finali con molte particelle.

La combinazione di tutti i risultati degli studi sopraelencati permette di estrarre i valori delle costanti di accoppiamento tra il bosone di Higgs e le altre particelle e di verificarne la compatibilità con il modello. Questo controllo di consistenza può avvenire in diversi modi. L’approccio che si sta sviluppando va sotto il nome di “Effective Field Theory” (EFT) e consiste nell’ipotizzare l’esistenza di deviazioni negli accoppiamenti rispetto alle previsioni del Modello Standard, di introdurle come parametri liberi nel modello che descrive i dati e nel cercare di estrarle dai dati mediante una procedura di fit. Per il momento entro le incertezze sperimentali tutte queste deviazioni risultano nulle, ma questi test diventeranno sempre più sensibili all’aumentare della statistica raccolta ed analizzata.

Uno degli accoppiamenti previsti dal Modello Standard è quel del bosone di Higgs con se stesso, misurabile dalla produzione di coppie di bosone di Higgs. Questo processo dovrebbe essere talmente raro da non essere osservabile nei dati ad oggi disponibili, ma viene ugualmente ricercato attivamente in quanto la sua osservazione indicherebbe chiaramente la presenza di fenomeni nuovi, non contemplati dal Modello Standard.

Upgrade del sistema calorimetrico (a cura di Marianna Testa e Francesco Tartarelli)

Il gruppo che lavora al calorimetro ad argon liquido di ATLAS ha mostrato i progressi nella progettazione e sviluppo di nuove schede di elettronica che sostituiranno quelle attualmente in uso nel rivelatore a partire dal 2020. Queste schede permetterano una più efficace preselezione veloce degli eventi interessanti rispetto agli eventi di fondo. Prototipi di queste schede sono in via di realizzazione e verso la metà del 2017 saranno testate al CERN insieme a parti realizzate da altri istituti internazionali. Se il test avrà successo si potrà procedere con la produzione industriale di tutte le schede necessarie per il calorimetro.

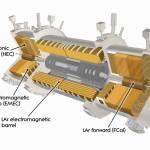

Il gruppo italiano che si occupa del calorimetro adronico dell’esperimento ATLAS (TileCal) è impegnato nello studio della risposta dei fotomoltiplicatori (PMT) di TileCal , sia attraverso l’analisi dei dati di calibrazione, sia con un apparato di test progettato e installato a Pisa (Fig. 3) che permette di studiare la variazione nel tempo della risposta di PMT eccitati con luce Laser o LED, che integrano una notevole quantità di carica elettrica sul catodo. Questi studi sono fondamentali per valutare come i PMT si comporteranno nella fase di alta luminosità di LHC che è prevista cominciare nel 2026.

Negli ultimi mesi il gruppo italiano sta partecipando anche ad uno studio di fattibilità sulla possibilità di aumentare la granularità del calorimetro adronico utilizzando dei PMT multi-anodo almeno in alcuni strati del calorimetro stesso. Lo scopo finale di questo upgrade sarebbe quello di migliorare la rivelazione di jets provenienti dal decadimento di particelle molto pesanti e studiarne le eventuali sotto-strutture. Il progetto è molto impegnativo sia dal punto di vista della raccolta della luce di scintillazione che per le modifiche richieste all’elettronica di lettura. La collaborazione valuterà a breve se sia opportuno portarlo avanti.

Fig. 3: Schema dell’apparato sperimentale per loo studio della variazione nel tempo della risposta di PMT eccitati con luce laser.

Upgrade dello spettrometro per muoni (a cura di Alessandro Polini, Franco La Cava, Mariagrazia Alviggi)

Relativamente alle attività di upgrade dei rivelatori con tecnologia RPC (Resistive Plate Chambers), che in ATLAS forniscono i segnali di trigger per muoni nella regione barrel, per la presa dati dal 2019 in avanti si prevede di integrare il sistema corrente con 32 nuove camere ciascuna con un tripletto di gap di ridotto spessore, elettronica di Front-End di nuova generazione e differenti condizioni di lavoro. Queste camere (denominate BIS7/8) andranno ad instrumentare la regione di transizione tra barrel ed endcap con lo scopo di ridurre sensibilmente il rate di trigger dovuto a false coincidenze. Gli sviluppi ed i test con fasci sui prototipi hanno mostrato risultati promettenti. Il progetto BIS7/8 si propone anche come attività intermedia in vista dell’upgrade di Fase 2 (presa dati dal 2025) che prevede l’aggiunta di 192 nuove camere ad integrare la regione barrel con un nuovo layer interno (denominato BI). L’aggiunta del layer BI consentira’ di estendere le prestazioni in termini di accettanza, rate di trigger e longevita’ del sistema di muoni per il programma ad alta luminosita’ di LHC.

Per la Fase II dell’Upgrade del rivelatore di muoni a piccolo angolo, il Large Eta Muon Tagger, si stanno inoltre sviluppando nuovi Micro Pattern Gas Detectors in grado di rivelare tassi di particelle molto elevati, dell’ordine di qualche MHz/cm2. Una così elevata densità di particelle, tutte presenti in tempi molto vicini tra loro, richiede l’utilizzo di un rivelatore con una altrettanto elevata densità di elementi sensibili (granularità), in grado inoltre di rispondere ‘molto velocemente’ alle sollecitazioni prodotte dalle particelle incidenti. Il rivelatore in via di sviluppo dovrà essere in grado di fornire in poche decine di nanosecondi il segnale del passaggio delle particelle, consentendo inoltre di ricostruire la loro traiettoria con un errore di poche centinaia di micrometri. Le tecniche di produzione di tali rivelatori sono simili a quelle utilizzate per la produzione dei circuiti stampati presenti in tutti gli oggetti elettronici della nostra vita quotidiana (telefonini, televisori, computer, etc…). Le maggiori difficoltà vengono, oltre che dalla capacità di fornire le prestazioni richieste, anche dalla necessità di inserire sia il rivelatore che l’elettronica necessaria alla sua lettura in spazi notevolmente ridotti; si pensi ad esempio che un piccolo rivelatore di circa 5×5 cm2 potrebbe avere circa 1000 canali di elettronica per la sua lettura, da posizionare in modo da non creare spazi morti per la rivelazione delle particelle.

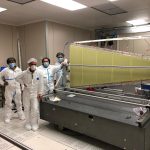

In figura 4 è mostrato, a titolo di esempio, il disegno di una MicroMegas (un tipo di Micro Pattern Gas Detector) con circa 800 elementi di lettura (pads) distribuiti su di una superficie di circa 5×5 cm2 (zona nel rettangolo rosso); come si può vedere lo spazio occupato in tale disegno già solo dalle linee conduttrici (linee rosa in figura) necessarie alla sua lettura è molto maggiore di quello della superficie attiva; bisognerà quindi trovare una soluzione che consenta di disporle su più piani, sul retro del rivelatore ed insieme alla relativa elettronica di lettura, la quale dovrà inoltre essere resistente alle radiazioni. In figura 5 è mostrato il prototipo realizzato in base al disegno di fig.4.

Nell’ultimo anno è continuato il lavoro per la preparazione dei nuovi rivelatori di muoni in avanti (New Small Wheel) che sostituiranno quelli attualmente installati (Small Wheel) in vista del RUN III di LHC con luminosità di alcune unità di 10^34 cm^-1 s^-1. I due rivelatori NSW di forma circolare e divisi in 16 settori avranno un diametro di 10 m e saranno posti a ±7 m dal punto di interazione. A questo progetto partecipano fisici delle Università e delle Sezioni INFN di Cosenza, Napoli, Lecce, Pavia, Roma Sapienza, Roma TRE e dei Laboratori Nazionali di Frascati che prepareranno 32 camere micromegas pari a un quarto del totale. In maggio è stato ultimato un modulo di prova (modulo 0) a dimensione finale di queste camere (fig. 6) poi provato al CERN su un fascio di test con buoni risultati (efficienza di rivelazione prossima al 100% e risoluzione sulla posizione delle tracce pari a circa 80 micron, si veda http://webusers.fis.uniroma3.it/atlas/?p=1024). E’ in corso l’allestimento delle camere pulite e delle aree sperimentali che serviranno per la realizzazione ed il test delle 32 camere di competenza italiana. La produzione di questi moduli inizierà la prossima primavera. A questa attività si unisce il contributo di fisici di Napoli e Roma Sapienza per il trigger nella NSW. Questi sono impegnati nella preparazione di 32 schede per il processamento dei segnali da camere di trigger small Thin Gap Chamber che precedono e seguono le camere micromegas. Il primo prototipo di queste schede è attualmente sotto test con buoni risultati (fig. 7) e si prevede di iniziare la costruzione a fine 2017.

Fig. 6: Foto del modulo di prova in scala 1:1 delle camere SM1 della NSW. La foto è stata scattata nell’area sperimentale del CERN dove il rivelatore è stato testato su una linea di fascio nell’estate del 2016

Fig. 7: La scheda Pad Trigger Logic Board per il processamento dei segnali dalle pad nelle camere small Thin Gap Chamber per il trigger di muoni nelle NSW

Sessione di upgrade di LUCID, ITk, FTK e DAQ (a cura di Federico Lasagni)

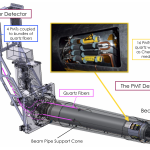

La sessione di upgrade è proseguita con con la presentazione delle attività dei rivelatori Forward di ATLAS. Il rivelatore a effetto Cherenkov LUCID è stato aggiornato con successo per far fronte alle condizioni del Run 2, con l’utilizzo di nuovi PMT, di un nuovo sistema di calibrazione online basato su una sorgente di 207Bi e di un nuovo sistema di elettronica. Grazie a questo LUCID è a partire dal 2015 il rivelatore ufficiale di luminosità di ATLAS, sia online che per run di fisica, con una precisione del 2.1% nel 2015 data dalle calibrazioni con VdM scan e con un’incertezza preliminare del 4.5% nei dati 2016. Per gli upgrade di Fase 1 e 2 è in studio una versione di LUCID che osservi luce Cherenkov prodotta in fasci di fibre di quarzo, con un primo prototipo installato come parte del LUCID attuale. Bologna, Alberta e Lund costituiscono attualmente

la collaborazione LUCID. L’insieme dei rivelatori del progetto AFP è stato installato sul lato C di ATLAS, a 205 e 217 m dal punto di interazione, con lo scopo di studiare le proprietà degli eventi diffrattivi, la struttura dei pomeroni, la descrizione

fatta in QCD della diffrazione, la struttura del protone e di ricercare segnali di nuova fisica. Nel 2017 si prevede di installare il secondo braccio di AFP sul lato A di ATLAS. Il rivelatore ZDC ha funzionato con successo nel Run 1 e ha partecipato, di recente, alla presa dati in collisioni p-Pb grazie all’uso del sistema di acquisizione del vecchio LUCID. Il piano è quello di aggiornare il rivelatore per il 2018 utilizzando un radiatore liquido che possa essere facilmente sostituito una volta irradiato eccessivamente.

Durante la sessione è stato presentato lo stato del progetto FTK, che si propone di ricostruire le tracce del tracciatore interno di ATLAS alle frequenze di output del Livello 1 di trigger con una latenza massima di circa 100 microsecondi. Per fare questo impiega FPGA e Memorie Associative, chip custom basati su memorie CAM, attualmente alla versione AM06. I prototipi funzionano come richiesto e non è necessario un ulteriore redesign. La produzione è iniziata con alta efficienza (>80%) e i primi 8000 chip sono attesi per gennaio 2017. Il fattore più critico è al momento il consumo di corrente, che ha richiesto particolare attenzione nel design delle schede AMB, di cui 64 saranno consegnate entro aprile 2017. L’integrazione di FTK nel sistema di acquisizione di ATLAS è in corso e il software viene aggiornato regolarmente.

I restanti interventi si sono concentrati sull’upgrade di Fase 2, ovvero per quello che viene chiamato HL-LHC, per il quale è in preparazione il TDR per il 2017. Il progetto prevede la possibilità di raggiungere una luminosità istantanea di 7.5×1034 cm-2 s-1 e una luminosità integrata di 4000 fb-1. Anche se non assicurata, questa opzione va ad influenzare il design di tutti gli upgrade, in modo da non avere una perdita significativa di efficienza dei rivelatori una volta oltre la precedente stima, conservativa, di 3000 fb-1. Buona parte dei design per gli upgrade di ATLAS non prevedono ritardi significativi, con i TDR attesi per il 2017, da giugno a dicembre, mentre ci sono ancora alcuni progetti che mancano di una parte dei fondi necessari.

Uno degli argomenti ancora in discussione è l’architettura della TDAQ di ATLAS, per la quale sono stati presentati due modelli: uno con un singolo livello, nel quale tutte le decisioni di trigger devono essere prese in 10 microsecondi, e uno a due livelli, con latenze rispettivamente di 5 e 20 microsecondi.

Nell’ambito degli upgrade di Fase 2 è stato illustrato lo stato di ITk, il sostituto dell’attuale tracciatore interno di ATLAS. Diverse configurazioni dei rivelatori al silicio sono in discussione e per ognuno sono state presentate simulazioni MC, che hanno messo in evidenza vantaggi e svantaggi in diverse regioni dello spazio delle fasi delle particelle da tracciare. Sono inoltre in fase di studio diverse tecnologie per i sensori stessi: 3D, planari e CMOS. Queste possono essere combinate per sfruttare i vantaggi di ognuna di esse in settori diversi di ATLAS. I gruppi italiani di Trento e Genova sono al lavoro sui sensori 3D, per i quali sono sono stati prodotti nuovi prototipi ora in fase di test e analisi. I gruppi di Genova, Milano e Bologna stanno, invece, studiando sensori ibridi che combinino sullo stesso wafer elettronica CMOS e sensore ad alto

voltaggio (Bipolare/DMOS). La scelta delle tecnologie da utilizzare dovrà avvenire entro dicembre 2018, per iniziare la produzione nel 2020.

Le richieste stringenti sui trigger per Fase 2 richiederanno un sistema di tracciamento Hardware simile a FTK anche in questa fase di LHC. Al momento è in corso di studio un doppio sistema, a bassa latenza da integrare a L1 (se si sceglierà una strada a due livelli di trigger) e uno che svolga la ricostruzione dell’intero evento per il trigger di livello più alto. Il sistema è simile a FTK, ma richiederà di portare all’estremo la tecnologia, dovendo raddoppiare il numero di tracce da ricostruire e ridurre la latenza di un fattore 10.

Infine, è stato presentato l’upgrade del trigger muonico per la Fase 2 di LHC, che richiederà grandi cambiamenti per far fronte alle nuove richieste di trigger e per migliorare la performance attuale. Già nella Fase 1 è in corso l’aggiunta di nuove camere RPC per un miglioramento della copertura e delle prestazioni in generale in aree di ATLAS dove queste sono particolarmente basse. Inoltre sarà necessario una nuova elettronica di trigger da posizionare all’esterno del rivelatore per maggiore flessibilità. Varie proposte per il trigger di L0 basato sulle camere MDT sono attualmente in via di

discussione.

Comments RSS Feed